Razem: 0,00 zł

Czym są superkomputery i jak wykorzystują natywne technologie chmurowe?

Technologia i komputery rozwijają się dziś tak szybko, że często nawet nie zdajemy sobie z tego sprawy. Urządzenia, które jeszcze 20 lat temu nazywano superkomputerami, dziś przegrałyby walkę z wielokrotnie mniejszymi smartfonami czy tabletami. I choć współczesne smartfony dysponują dużymi możliwościami, w żaden sposób nie mogą konkurować z potężnymi jednostkami, które wykorzystywane są w najlepszych na świecie ośrodkach badawczych. Jaką mocą dysponują najpotężniejsze superkomputery na świecie? W jaki sposób wykorzystują przetwarzanie natywne w chmurze?

Superkomputery – czym różnią się od zwykłych komputerów?

Nie da się ukryć, że dane są dziś paliwem napędzającym świat. Ich gromadzenie, przetwarzanie i wyciąganie wniosków na podstawie ich analizy niesie za sobą szereg wyzwań. Z problemem tym mierzy się wiele organizacji, jednak wolumen danych, jakie wykorzystują, jest stosunkowo niewielki. Nieporównywalnie mniejszy od wolumenów, z jakimi pracują środowiska akademickie, wiodące ośrodki badawcze czy organy administracji państwowej. To właśnie tego typu podmioty zgłaszają zapotrzebowanie na niezwykle potężne maszyny, które w ułamkach sekund będą procesować ogromne zbiory danych, wykonywać na nich zaawansowane operacje i rozwiązywać konkretne problemy biznesowe.

Superkomputerów jest na świecie wiele, jednak swoja obecnością w czołówce najsilniejszych maszyn obliczeniowych na świecie cieszą się zwykle dość krótko. Postęp technologiczny sprawia, że zmiany na podium następują niezwykle szybko.

Jednym z najwybitniejszych w historii rozwiązań jest opracowany przez IBM i NVIDIA superkomputer Summit, który zadebiutował w 2018 roku i cieszył się pozycją lidera do momentu debiutu Fagoku, a także wykorzystywany przez amerykańską Narodową Administrację Bezpieczeństwa Nuklearnego do przeprowadzania symulacji użycia broni jądrowej superkomputer Sierra. Bardzo możliwe, że ranking ten już za kilka miesięcy ponownie ulegnie zmianie – na 2023 rok planowany jest bowiem debiut Aurory, która będzie drugim po superkomputerze Frontier eksaskalowym komputerem w USA.

Cloud native, czyli natywne technologie chmurowe

Właściwe adresowanie wyzwań współczesnego świata wymaga z jednej strony właściwej infrastruktury systemowej – tj. superkomputerów o ogromnej mocy obliczeniowej, a z drugiej wsparcia ze strony technologii, która umożliwi lepszy do nich dostęp. Istotne zmiany na tym polu poczyniono już kilka lat temu, kiedy superkomputery zaczęły wkraczać do środowiska chmurowego.

Dziś większość serwerów chmurowych posiada stosunkowo niewielką moc obliczeniową – wystarczającą do tego, by obsłużyć większość standardowych procesów IT, jednak nie na tyle dużą, by poradzić sobie z najbardziej złożonymi procesami czy też koniecznością przeprocesowania tego samego cyklu kilkaset czy nawet kilka tysięcy razy.

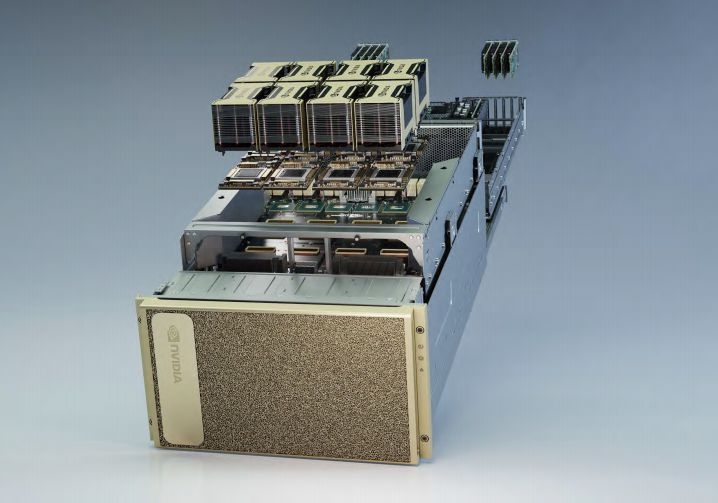

BlueField DPU wspiera odciążanie zadań związanych z bezpieczeństwem, komunikacją i zarządzaniem, aby zwiększyć wydajność superkomputera w chmurze.

Źródło: https://blogs.nvidia.com/blog/2021/04/14/what-is-a-cloud-native-supercomputer/

Między innymi z tego względu superkomputery zaczęły coraz śmielej wkraczać do środowiska chmurowego i dzięki temu dziś chociażby chmura Azure z powodzeniem adresuje potrzeby zarówno standardowych klientów, jak i tych, którzy wymagają ogromnych mocy obliczeniowych, by realizować zaawansowane symulacje czy złożone procesy uczenia maszynowego. Systemy obliczeniowe klasy HPC są dla dostawców rozwiązań chmurowych dość kosztowne we wdrożeniu, a jednocześnie popyt na tego typu usługi jest obecnie stosunkowo niewielki. Na dzień dzisiejszy zapotrzebowanie na ogromne moce obliczeniowe zgłaszają wyspecjalizowane podmioty badawcze, które często dysponują własną infrastrukturą systemową. Można jednak przypuszczać, że z upływem czasu i wraz z rosnącym poziomem wykorzystania możliwości AI przez biznes i jednostki administracji państwowej, popyt na usługi tego typu istotnie się zwiększy.

Cloud-Native Supercomputer od NVIDIA

NVIDIA może się pochwalić licznymi doświadczeniami w obszarze budowy superkomputerów i nie ustaje w swych staraniach, by regularnie prezentować światu coraz bardziej imponujące jednostki. Doskonałym przykładem jest chociażby budowany od ubiegłego roku superkomputer Earth-2, który ma służyć przeprowadzaniu najróżniejszych symulacji klimatycznych, a także informować o zbliżających się kataklizmach. Ma dysponować ogromną mocą obliczeniową, która pozwoli na przeprowadzenie znacznie bardziej precyzyjnych (obejmujących cały świat) obliczeń.

W ofercie producenta znaleźć można również wiele innych potężnych superkomputerów, które można kupić lub wykorzystywać w ramach subskrypcji - DGX SuperPOD. Jest to doskonałe rozwiązanie dla mniejszych laboratoriów i ośrodków badawczych, które nie dysponują odpowiednio dużym budżetem, by stworzyć własną infrastrukturę, jednak są gotowe płacić za czasowe jej użytkowanie.

SuperPOD NVIDIA DGX nowej generacji, wyposażony w jednostki DPU NVIDIA BlueField-2, jest pierwszym na świecie superkomputerem typu multi-tenant działającym w chmurze.

W połowie listopada firma poinformowała o rozpoczęciu współpracy z Microsoft, by wspólnymi siłami zbudować chmurowy superkomputer i zapewnić klientom jeszcze większe możliwości w zakresie realizacji projektów wykorzystujących sztuczną inteligencję. Chmura Azure już dziś wykorzystuje rozwiązania partnera – w tym procesory graficzne NVIDIA A100, jednak rozpoczęta właśnie współpraca zakłada dostarczenie jeszcze lepszych osiągów, w czym pomóc mają procesory graficzne NVIDIA H100 i platformy sieciowe NVIDIA Quantum-2 InfiniBand.